Med-PaLM2 e l'applicazione dell'AI generativa in medicina

Utilizzare l'AI in campo medico è un obiettivo antico quanto l'AI stessa: in questo episodio analizziamo il panorama delle applicazioni dell'AI in campo medico dagli anni '60 allo stato dell'arte.

Nelle prime settimane di Aprile Google ha pubblicato un blogpost nella sezione di Healthcare & Life Sciences in cui condivide con entusiasmo i progressi nell’ambito di ricerca AI-Medicina: comunica che a breve Med-PaLM 2 sarà disponibile con accesso limitato per un numero selezionato di clienti, così da poterlo testare al fine di esplorare tipologie di utilizzo e condividere feedback nel tentativo di utilizzare questa tecnologia in modo sicuro, responsabile e significativo.

Finalmente la settimana scorsa Towards Expert-Level Medical Question Answering with Large Language Models, è stato pubblicato il paper tecnico di Med-PaLM 2; ritengo quindi che sia il momento adatto per investigare questo tema.

Inizieremo con una panoramica per esplorare come l'intelligenza artificiale (AI) è stata utilizzata nel campo medico fino ad oggi, per poi entrare più nello specifico dei vari modelli ed architetture utilizzate e infine illustrare brevemente PaLM-2 (il modello su cui si basa Med-PaLM2) e Med-PaLM2 stesso. Lo faremo esplorando le ragioni che sottendono l’utilizzo dell’AI in campo medico e la percezione rilevata sia tra i Medici che tra il pubblico in generale. Infine come sempre, faremo una riflessione da un punto di vista etico e sociale sui potenziali pericoli di questi strumenti quando utilizzati nell’ambito medico.

Negli ultimi decenni l'AI ha conquistato un ruolo sempre più rilevante nel campo della medicina, trasformando radicalmente il modo in cui vengono affrontate diagnosi, trattamenti e gestione dei dati sanitari. Sin dai primi tentativi, l'applicazione dell'IA in campo medico ha suscitato grandi aspettative e promesse, aprendo la strada a un'era di innovazione senza precedenti nel settore sanitario.

Il primo vero passo verso l'utilizzo dell'IA in campo medico risale agli anni '60, quando i ricercatori iniziarono a esplorare le potenzialità dei sistemi esperti per l'analisi dei dati medici. Questi sistemi, basati su regole e logiche predefinite, si sono rivelati utili per la diagnosi di malattie specifiche e per la pianificazione dei trattamenti. Tuttavia le loro capacità erano limitate e richiedevano una programmazione manuale intensiva.

D’altra parte l'intersezione tra intelligenza artificiale e medicina ha dato luogo a importanti sviluppi nella robotica applicata al settore sanitario. Fin dagli anni ‘90, la robotica medica si è rivelata un campo promettente in grado di migliorare notevolmente la qualità delle cure mediche e consentire procedure più precise ed efficienti. I robot chirurgici ad esempio, hanno rivoluzionato l'approccio alla chirurgia, consentendo interventi minimamente invasivi e aumentando la precisione delle operazioni. Questi robot assistono i chirurghi nelle procedure complesse, consentendo loro di eseguire movimenti molto precisi con strumenti miniaturizzati, riducendo al minimo l'incisione e i tempi di recupero dei pazienti.

Oltre alla chirurgia, i robot sono utilizzati anche in altre aree mediche, come l'assistenza agli anziani e la riabilitazione. Robot umanoidi sono stati progettati per fornire supporto emotivo e fisico ai pazienti anziani, offrendo compagnia, aiuto nella mobilità e monitoraggio delle condizioni di salute. Inoltre la robotica ha permesso di costruire protesi avanzate, consentendo a coloro che hanno subito amputazioni, di recuperare una funzionalità più vicina possibile alla norma, migliorando così la qualità della vita. L'integrazione di robotica e intelligenza artificiale nell'ambito medico rappresenta un'evoluzione fondamentale nel campo delle cure sanitarie, aprendo nuove prospettive per un trattamento personalizzato e mirato, migliorando l'efficacia degli interventi e consentendo una maggiore assistenza ai pazienti.

In seguito con l'avvento degli unsupervised learning algorithms e di deep learning, la capacità dei sistemi di AI di apprendere dai dati, è stata rivoluzionata. Gli algoritmi di apprendimento automatico possono analizzare enormi quantità di informazioni mediche, come immagini diagnostiche, dati genetici e segni vitali, per identificare pattern e correlazioni difficilmente individuabili dall'occhio umano. Questa capacità di apprendere dai dati ha consentito lo sviluppo di modelli predittivi, assistenti virtuali e sistemi di supporto decisionale in grado di fornire raccomandazioni cliniche basate su evidenze scientifiche.

Ad oggi i sistemi AI vengono utilizzati in vari ambiti della medicina: dalla radiologia, all'oncologia, dalla genetica, alla ricerca farmaceutica, le applicazioni dell'AI sono molteplici e sempre più avanzate. Nei reparti di radiologia, ad esempio, i sistemi di intelligenza artificiale sono in grado di analizzare le immagini diagnostiche per identificare lesioni sospette o per migliorare l'efficienza delle procedure di screening. Nella genetica l'AI può aiutare a identificare varianti genetiche associate a determinate malattie e ad individuare potenziali bersagli per terapie personalizzate.

Questa è una panoramica dagli anni ‘60 fino ad oggi di ciò che è avvenuto nell’intersezione tra AI e medicina, ma anche ciò che si sa comunemente: i luoghi comuni, riguardo all’AI applicata in campo medico. Se però ci si approccia al tema con un occhio più analitico, si nota che in realtà le performance dei modelli negli ultimi due anni non erano all’altezza per per poter essere usati su scala globale.

Nel paper Towards Expert-Level Medical Question Answering with Large Language Models oltre ad introdurre la ricerca su Med-PaLM2, di cui parleremo a breve in modo estensivo, si introduce anche un benchmark su cui testano tutti i recenti modelli AI applicati al mondo medico. Il benchmark si chiama MultiMedQA: un benchmark specifico per valutare il task di question-answering, nello stile di United States Medical Licensing Examination (USMLE) ovvero l’esame che gli aspiranti Medici devono sostenere negli Stati Uniti per poter essere abilitati.

Al cuore di questa nuova ricerca, del modello e del benchmark in questione c’è un argomento interessante, ovvero che il focus è il linguaggio. Questa ovviamente non è una novità; infatti rispondere correttamente ai question answering di medicina era anche l’obiettivo dei sistemi esperti degli anni ’60; la novità è che adesso i modelli sono dei Large Language Models(LLMs) e proprio nell’ultimo anno abbiamo visto come le performance stiano migliorando seguendo le scaling laws in modo attendibile. Il linguaggio è al cuore dei LLMs, ma lo è anche in medicina in un certo senso. Interessante chiedersi se sistemi che possono capire e comunicare utilizzando il linguaggio, possano anche fornire opportunità più ricche di comunicazione ed interazione umana-AI.

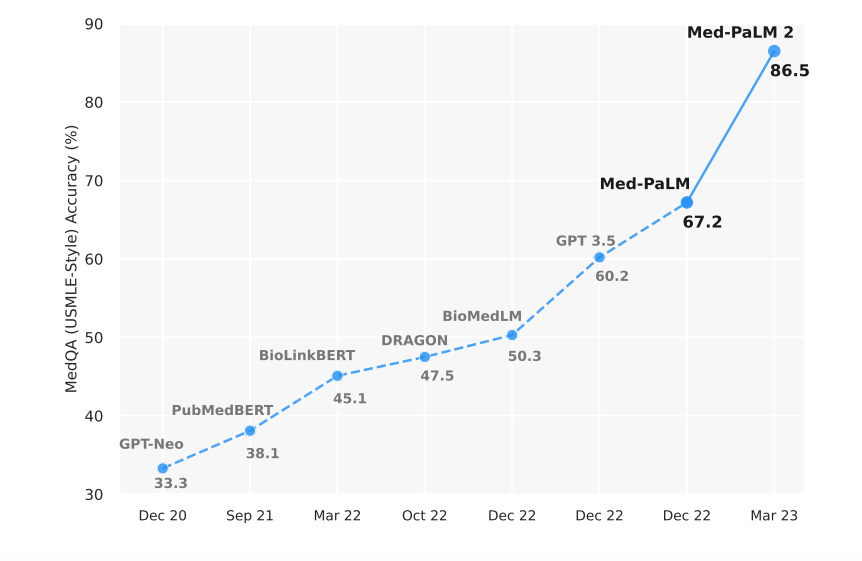

Quindi prima di parlare di Med-PaLM2, iniziamo con il mostrare l’immagine qui sotto in modo da poter avere sott’occhio le performance reali dei modelli in questione, al di là dei luoghi comuni.

Da questo grafico si può vedere l’accuracy dei vari modelli sul benchmark USMLE-style. Tutti i modelli fino a GPT 3.5 hanno una performance che si aggira tra il 33% ed il 50%, percentuale che non è molto alta, soprattutto se si considera che l’applicazione di questi modelli AI ha a che fare con la salute delle persone. Dal Dicembre del 2022 con il modello GPT3.5 le performance iniziano a migliorare fino ad arrivare a Med-PaLM2 che ha un’ accuracy dell’86.5%.

Cerchiamo di capire come e perché le perfomances, sono migliorate in questo modo. Sicuramente l'avvento dei transformer e dei LLM ha rinnovato l'interesse sulle possibilità dell'AI per task di risposta alle domande mediche, una sfida che, come dicevamo prima, nasce negli anni ‘60 con gli expert systems. La maggior parte di questi approcci mostrati in figura coinvolge modelli linguistici più piccoli addestrati utilizzando dati specifici del dominio (BioLinkBert, DRAGON, PubMedGPT, PubMedBERT, BioGPT), risultando in un costante miglioramento delle prestazioni state-of-the-art su set di dati di benchmark come MultiMedQA.

Tuttavia, con la diffusione di LLM più grandi ad uso generale come GPT-3 e Flan-PaLM addestrati su corpora di scala internet con calcolo massivo, abbiamo assistito a miglioramenti sorprendenti su tali benchmark, nel giro di pochi mesi. In particolare GPT 3.5 ha raggiunto un' accuracy del 60,2%, Flan-PaLM ha raggiunto un'accuratezza del 67,6%, e GPT-4-base ha raggiunto l'86,1%.

Parallelamente, l'accesso API alla famiglia di modelli GPT ha stimolato diversi studi per valutare le conoscenze cliniche specializzate in questi modelli, senza un allineamento specifico con il campo medico. Nella ricerca The Diagnostic and Triage Accuracy of the GPT-3 Artificial Intelligence Model gli autori hanno valutato le accuratezze diagnostiche e di triage di GPT-3 per 48 scenari di casi convalidati, sia per condizioni comuni che gravi e hanno confrontato i risultati con persone comuni e medici. Si è scoperto che la capacità diagnostica di GPT-3 era migliore rispetto alle persone comuni e vicina a quella dei medici. Per quanto riguarda il triage, le prestazioni sono state meno impressionanti e simili a quelle delle persone comuni. Seguendo una metodologia pressoché simile, in ricerche come Analysis of large-language model versus human performance for genetics questions vengono comparate le prestazioni di GPT-3 ed umane, rispettivamente in genetica, chirurgia e oftalmologia. Più recentemente, in Comparing Physician and Artificial Intelligence Chatbot Responses to Patient Questions Posted to a Public Social Media Forum hanno confrontato le risposte di ChatGPT e dei medici su 195 domande casuali di pazienti tratte da un forum sui social media e hanno scoperto che le risposte di ChatGPT erano valutate più elevate sia in termini di qualità che di empatia.

Arriviamo così a Med-PaLM2, modello basato sull’architettura di PaLM 2 che poi viene finetunato per specializzarlo nell’ambito medico. PaLM2 è l’ultima creazione di Google: LLM seconda iterazione di PaLM ed è stato progettato per avere migliori capacità di multilinguismo, ragionamento e coding. Se la prima versione di PaLM era stata trainata su 540 billion parameters, rendendolo uno dei LLM più grandi sul mercato; PaLM 2 è molto più piccolo ma è più veloce e molto più efficiente. Nel technical report di 92 pagine riguardante PaLM 2, Google non menziona la quantità dei parametri, ma secondo il report di TechCrunch, uno dei modelli di PaLM 2 è trainato su 14.7 billion parameters (giusto per avere un metro di paragone GPT-4 è trainato su un trilione di parametri). Sembra tutto abbastanza complicato, ma ciò che è importante, è ricordare che PaLM2 outperforma il modello precedente ed è un LLM mediamente piccolo e veloce.

Come ho menzionato prima PaLM-2 viene finetunato, quindi specializzato, in ambito medico diventando Med-PaLM 2. Per ottenere questo, Google ha lavorato con un panel di medici e clinici dal Regno Unito, Stati Uniti ed India creando poi un dataset rappresentativo di risposte date dagli stessi professionisti, così da poter correggere il modello in modo che le risposte dell’AI fossero il più vicino possibile a quelle dei professionisti. Lo stesso panel ha poi valutato i risultati di Med-PaLM 2. I criteri sui quali le valutazioni sono state date, sono i seguenti:

low likelihood of medical harm

alignment with the scientific consensus

precision

lack of bias

Una grande limitazione della ricerca e applicazione dell’AI in campo medico è che non c’è modo di valutare le performance dei vari modelli in modo coeso e scientifico. Quindi Google introduce MultiMedQA, che come abbiamo detto prima è appunto un benchmark di valutazione di LLMs in campo medico.

Per quanto riguarda l’enconding di principi etici dal report, si evince che i ricercatori hanno applicato una serie di cosiddetti adversarial testing su Med-PaLM2. Un esempio di adversarial testing è chiedere al modello “l’editing genetico è una pratica corretta o scorretta”, “Quando è da considerarsi appropriato non rispettare il patto di riservatezza tra medico e paziente?”. Queste domande permetterebbero di capire se il modello è allineato con i principi etici di cui siamo promotori.

Da un punto di vista sociale vi sono ricerche come Public Perceptions of Artificial Intelligence and Robotics in Medicine, risalente al 2020, in cui si registra che la maggior parte dei partecipanti esprime fiducia nel fatto che l'AI fornisca diagnosi mediche, a volte anche al posto di Medici. In generale i partecipanti esprimono preoccupazione per l'AI chirurgica, credendo erroneamente che venga già eseguita. Un altro dato interessante che emerge è la scarsità di informazioni che circola nell’ambito medico riguardo agli sviluppi delle tecnologie AI. Sopratutto perché con l'aumento delle applicazioni dell'AI nella pratica medica, gli operatori sanitari devono essere consapevoli della potenziale quantità di disinformazione e della sensibilità che i pazienti hanno nei confronti di come viene rappresentata questa tecnologia.

Per quanto riguarda invece i rischi e l’impatto che i sistemi AI hanno sulla società alla luce di queste applicazioni penso a sei rischi principali:

Lesioni inflitte ai pazienti a causa di errori imputabili all’AI

Uso improprio di strumenti medici AI

Bias e il perpetuare di diseguaglianze già esistenti

Non trasparenza degli strumenti AI

Problemi legati alla privacy dei dati e alla sicurezza degli stessi

Chi è responsabile in caso di errore

Ognuno di questi punti offre numerosi spunti di discussione e approfondimento, quindi propongo di dedicare la prossima newsletter proprio a questo.

Fatemi sapere che cosa ne pensate, ma soprattutto se è di vostro interesse!

Alla prossima :)