Multimodalità, PaLM-E, e GPT4: quali abilità mancano per arrivare all'AGI?

Una riflessione sulla relazione tra modelli multimodali, come PaLM-E e GPT4 e le abilità caratteristiche dell'AGI

Il paper di PaLM-E è stato rilasciato da Google e TU- Berlin il 6 marzo 2023 ed è già notizia vecchia. Ieri è uscito GPT4. Ogni giorno, nel mondo dell’intelligenza artificiale (AI) c’è una nuova scoperta, un nuovo annuncio un nuovo passo verso il “progresso”, progresso che spesso prende il nome di intelligenza artificiale generale (AGI). Ogni volta che esce un modello nuovo viene da chiedersi: “Allora ci siamo? Questa è un’ AGI?”. Si cerca di capirci qualcosa, e un pò perché di AGI non si ha neanche una definizione, un pò perché comunque di sfide etico-politiche in ambito AI ce ne sono a bizzeffe, che l’AI sia AGI o meno, e quindi si cerca di affrontare quelle e non si trova una risposta riguardo all’AGI.

Tuttavia, quando si osservano gli ultimi modelli generativi e le loro forme multimodali, viene davvero da domandarsi che cosa manchi a modelli come PaLM-E per essere considerati AGI. Che cosa manca per arrivare all’AGI? Perché è importante saperlo? Saremo disposti ad ammettere che un modello X sia, effettivamente, un’ AGI? Questo issue si propone di presentare una riflessione sulla relazione tra modelli multimodali, come PaLM-E e GPT4 (del quale parleremo sicuramente in modo più approfondito nelle prossime puntate) e l’AGI.

Iniziamo dal principio, iniziamo con lo spiegare i concetti fondamentali. Se per AI generativa si intende quel tipo di AI che si concentra sulla creazione o sulla generazione di nuovi contenuti o dati, sotto forma di conversazione, linguaggio, immagini, video, suono, per AI multimodale si intende un nuovo paradigma di IA, in cui vari tipi di dati (immagini, testo, parlato, dati numerici) sono combinati con più algoritmi di elaborazione dell'intelligenza per ottenere prestazioni più elevate.

AGI, artificial general intelligence, è quella che in italiano chiamiamo intelligenza artificiale forte. Vi sono svariati test che vengono considerati come “il test per definire un’ AGI”. Per menzionarne alcuni: Turing Test di Turing, Coffe Test di Wozniak e il Robot College Student Test di Goertzel. Non esiste una definizione univoca, e diciamo pure che nella storia dell’AI il concetto di AGI è sempre stato presentato con un alone di fumo attorno. Un pò per creare confusione, un pò perché l’idea di arrivare all’AGI è come se fosse l’obiettivo implicito di tanti gruppi di ricerca. Almeno per capire che cosa si intende quando si parla di AGI in questo issue, la definiamo come la rappresentazione delle abilità cognitive umane generalizzate nel software, così che di fronte a un task sconosciuto, il sistema AGI possa trovare una soluzione.

La domanda che sorge spontanea è: esistono modelli considerati come AGI? La risposta è: no. Quali abilità mancano a modelli come PaLM-E per poter essere considerati tali?

PaLM-E è un modello di linguaggio multimodale generale a scopo unico per task di ragionamento embodied, task di linguaggio-visivo e task di linguaggio. PaLM-E trasferisce conoscenze dai domini linguaggio-visivo al ragionamento embodied - dalla pianificazione del robot in ambienti con dinamiche complesse e vincoli fisici, fino a rispondere alle domande su ciò che si può osservare del mondo reale. PaLM-E opera su frasi multimodali, ovvero sequenze di token in cui gli input da modalità arbitrarie (ad esempio, immagini, rappresentazioni neurali 3D o stati, in verde e blu) vengono inseriti insieme ai token di testo (in arancione) come input a un LLM, addestrato end-to-end. Detto in altre parole: PaLM-E non solo manipola e capisce il linguaggio naturale umano, ma comprende anche il mondo fisico. Sì, la “E” di PaLM-E sta per “embodied” (incarnato).

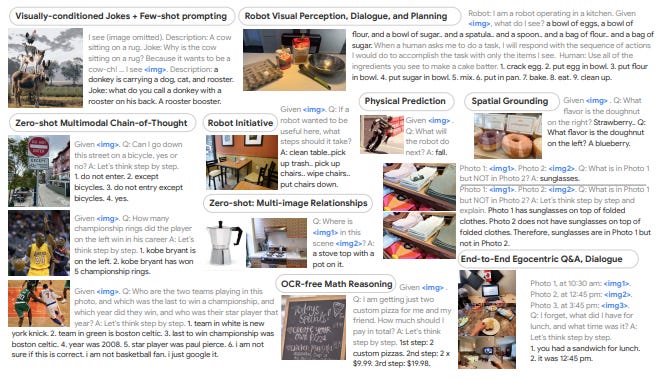

L’immagine qui sopra sottolinea alcune delle abilità topiche di PaLM-E ed è interessante confrontare questo spaccato con alcune delle affermazioni rilasciate da Anthropic sul tema AGI. Secondo il loro punto di vista la multimodalità, il ragionamento logico, la velocità di apprendimento, il trasferimento dell'apprendimento da un compito all'altro e la memoria a lungo termine, nel 2019 sembravano essere "muri" che avrebbero rallentato o fermato il progresso dell'IA. Vediamo, per esempio con questo modello, che se non altro il “muro” della multimodalità è caduto.

Alcune delle abilità che PaLM-E ha sono:

Physical Prediction: nell’immagine dove c’è il robot inclinato, PaLM-E riesce a predire che sta per cadere.

Zero-shot Multimodal Chain-of-Thought: immagine dove c’è Kobe Bryant. Lo riconosce a partire dalla sua immagine e si possono porre al modello domande in linguaggio naturale sulla carriera del giocatore di Basket

OCR-free Math Reasoning: immagine della lavagna su cui sono scritti i prezzi di alcuni piatti. PaLM-E performa operazioni matematiche.

Sembra così che si abbattano anche i muri del ragionamento logico, la velocità di apprendimento, il trasferimento dell'apprendimento da un compito all'altro. Su quali altri task dovrebbe performare per poter essere comparato all’essere umano? Questa qui sotto è un grafico che viene proposto nel paper di PaLM (il modello su cui si basa PaLM-E) e si nota che PaLM outperforms gli esseri umani presi in esame (in media).

Quali sono i task su cui gli esseri umani fanno meglio di PaLM? La tabella di sopra li enumera. I task su cui vengono comparati sono vari e disparati vanno dal: “mnist_ascii” ovvero la capacità di riprodurre e riconoscere numeri ascii al “hhh.alignment”, cioè la capacità di essere helpful, honest e harmless. Il fallimento di quest’ultimo task diventa molto chiaro quando si pensa alle allucinazioni di ChatGPT, ed è un fallimento che in una prospettiva più ampia preoccupa, perché riporta al problema del misalignment e del black box (quella che Anthropic chiama Mechanistic Interpretability).

Quindi, quale abilità manca alle AI per diventare AGI? Alcuni dicono la memoria, altri le capacità emotive, altri ancora la capacità di essere ironici. L’obiettivo di questo issue non è trovare una risposta, ma lanciare delle provocazioni e riflessioni. E’ corretto comparare le AI e gli esseri umani su i task su cui vengono comparati attualmente o si dovrebbero cambiare i parametri? Perché il tema dell’AGI è un tema così importante e al contempo così confuso? Il pericolo dell’AGI è un pericolo futuro a cui è effettivamente meglio che si avvicini piano, o è già qui? La conversazione rimane aperta e sembra essere più interessante che mai.